Pengertian Adversarial

Pengertian adversarial merujuk pada suatu pendekatan atau situasi di mana dua atau lebih pihak saling berhadapan dengan kepentingan yang bertentangan. Dalam konteks pembelajaran mesin, adversarial sering dikaitkan dengan serangan atau pertahanan terhadap model AI, di mana satu pihak berusaha mengecoh sistem, sementara pihak lain berupaya memperkuat keamanannya. Konsep ini juga dapat diterapkan dalam berbagai bidang seperti game theory, keamanan siber, dan psikologi.

Definisi dalam Konteks AI

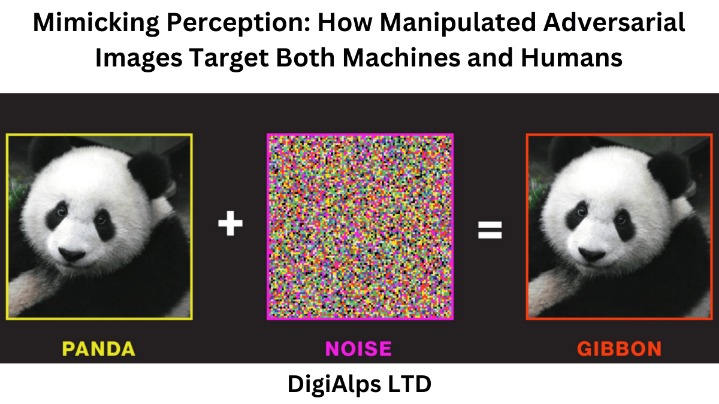

Pengertian adversarial dalam konteks kecerdasan buatan (AI) mengacu pada teknik atau skenario di mana model pembelajaran mesin diuji atau dimanipulasi melalui input yang dirancang khusus. Input ini, dikenal sebagai contoh adversarial, dibuat untuk mengecoh model sehingga menghasilkan prediksi yang salah, sementara tetap terlihat normal bagi manusia.

Definisi adversarial dalam AI juga mencakup metode pertahanan yang dikembangkan untuk melindungi model dari serangan semacam itu. Pendekatan ini melibatkan pelatihan model dengan data adversarial agar lebih robust terhadap gangguan. Konsep ini menjadi krusial dalam pengembangan sistem AI yang aman, terutama di bidang pengenalan gambar, pemrosesan bahasa alami, dan aplikasi kritis lainnya.

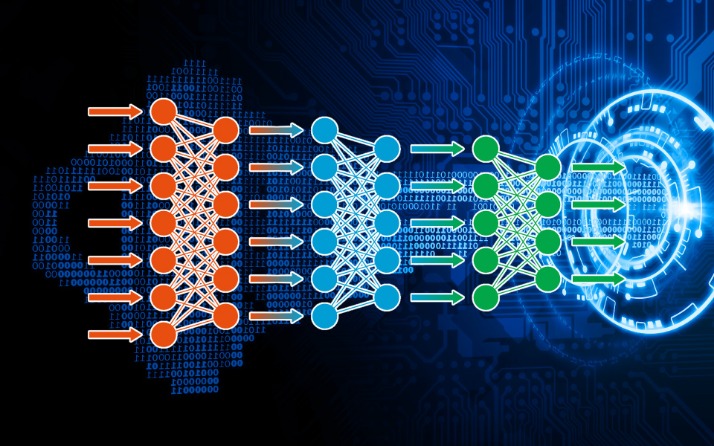

Secara lebih luas, adversarial dalam AI tidak hanya terbatas pada serangan dan pertahanan, tetapi juga mencakup kerangka kerja seperti Generative Adversarial Networks (GANs), di mana dua jaringan saraf—generator dan discriminator—berkompetisi untuk meningkatkan kualitas output. Dinamika ini menciptakan proses pembelajaran yang lebih efektif dalam menghasilkan data sintetis yang realistis.

Contoh Kasus Adversarial

Pengertian adversarial merujuk pada situasi di mana terdapat konflik atau pertentangan antara dua atau lebih pihak dengan tujuan yang berlawanan. Dalam dunia teknologi, istilah ini sering digunakan untuk menggambarkan interaksi antara sistem kecerdasan buatan (AI) dengan entitas yang berusaha memanipulasi atau mengecohnya.

Contoh kasus adversarial dalam AI adalah serangan adversarial pada sistem pengenalan gambar. Misalnya, seorang penyerang dapat memodifikasi gambar stop sign dengan perubahan piksel yang hampir tidak terlihat oleh mata manusia, tetapi menyebabkan model AI salah mengenalinya sebagai speed limit sign. Hal ini berpotensi berbahaya jika diterapkan pada kendaraan otonom.

Kasus lain adalah adversarial attack pada model pemrosesan bahasa alami (NLP), di mana input teks dimodifikasi dengan sinonim atau karakter khusus untuk mengelabui sistem klasifikasi. Contohnya, mengubah kata-kata dalam email phishing agar lolos dari deteksi spam filter tanpa mengubah maknanya bagi pembaca manusia.

Di sisi pertahanan, teknik adversarial training menjadi contoh penerapan konsep ini, di mana model AI sengaja dilatih dengan data yang sudah dimanipulasi agar lebih kebal terhadap serangan di masa depan. Pendekatan ini banyak digunakan untuk meningkatkan keamanan sistem pengambilan keputusan berbasis AI.

Contoh terkenal lainnya adalah Generative Adversarial Networks (GANs), di mana dua model neural network saling bersaing: satu sebagai pemalsu (generator) yang membuat data sintetik, dan satu sebagai detektif (discriminator) yang mencoba membedakan data asli dari palsu. Kompetisi ini menghasilkan peningkatan kualitas output secara terus-menerus.

Jenis-Jenis Serangan Adversarial

Jenis-jenis serangan adversarial dalam konteks kecerdasan buatan mencakup berbagai metode yang dirancang untuk mengecoh model pembelajaran mesin. Serangan-serangan ini dapat dibedakan berdasarkan cara kerja, tujuan, dan tingkat kerumitannya. Beberapa contoh umum meliputi serangan berbasis gradien, serangan kotak hitam, dan serangan berbasis perturbasi yang memanipulasi input dengan perubahan halus. Pemahaman terhadap jenis-jenis serangan ini penting untuk mengembangkan sistem pertahanan yang efektif dan menjaga keandalan model AI dalam skenario dunia nyata.

Evasion Attack

Jenis-jenis serangan adversarial dalam pembelajaran mesin dapat dikategorikan berdasarkan berbagai kriteria, termasuk pengetahuan penyerang, tujuan serangan, dan metode pelaksanaannya. Salah satu jenis yang paling umum adalah evasion attack, di mana penyerang memodifikasi input untuk menghindari deteksi atau menyebabkan klasifikasi yang salah tanpa mengubah model itu sendiri.

Evasion attack sering kali melibatkan perturbasi halus pada data input, seperti gambar atau teks, yang hampir tidak terdeteksi oleh manusia tetapi cukup signifikan untuk menipu model AI. Contohnya adalah menambahkan noise yang tidak terlihat pada gambar untuk mengelabui sistem pengenalan objek, sehingga gambar yang jelas diklasifikasikan secara salah.

Serangan ini dapat dilakukan dalam dua skenario: white-box attack, di mana penyerang memiliki akses penuh ke arsitektur dan parameter model, dan black-box attack, di mana penyerang hanya memiliki akses ke output model. Teknik seperti Fast Gradient Sign Method (FGSM) dan Projected Gradient Descent (PGD) sering digunakan dalam evasion attack berbasis gradien.

Selain itu, evasion attack dapat ditarget (targeted) atau tidak ditarget (untargeted). Pada serangan targeted, penyerang ingin model mengklasifikasikan input ke kelas tertentu yang salah, sedangkan pada untargeted attack, tujuannya hanya menyebabkan kesalahan klasifikasi tanpa peduli kelas outputnya.

Evasion attack menimbulkan risiko besar dalam aplikasi kritis seperti kendaraan otonom, sistem keamanan siber, dan diagnosis medis berbasis AI. Oleh karena itu, pengembangan teknik pertahanan seperti adversarial training, input preprocessing, dan deteksi anomali menjadi sangat penting untuk memitigasi ancaman ini.

Poisoning Attack

Jenis-jenis serangan adversarial dalam pembelajaran mesin mencakup berbagai teknik yang dirancang untuk memanipulasi model AI. Salah satunya adalah poisoning attack, di mana penyerang menyuntikkan data beracun ke dalam set pelatihan untuk mengganggu kinerja model.

Poisoning attack dapat dibagi menjadi dua kategori utama: targeted poisoning dan indiscriminate poisoning. Pada targeted poisoning, penyerang memengaruhi model agar salah mengklasifikasikan sampel tertentu, sedangkan indiscriminate poisoning bertujuan merusak kinerja model secara keseluruhan.

Contoh poisoning attack adalah label flipping, di mana penyerang mengubah label data pelatihan secara diam-diam. Misalnya, mengubah label “anjing” menjadi “kucing” dalam dataset gambar, sehingga model belajar hubungan yang salah antara fitur dan label.

Teknik lain adalah backdoor attack, di mana penyerang menyisipkan pola tertentu ke data pelatihan. Model akan berperilaku normal pada data biasa, tetapi menghasilkan output yang salah ketika pola backdoor muncul di input.

Poisoning attack sangat berbahaya karena dapat merusak model selama fase pelatihan, berbeda dengan evasion attack yang menyerang selama fase inferensi. Serangan ini sulit dideteksi karena data beracun sering kali terlihat sah dan hanya memengaruhi model secara bertahap.

Pertahanan terhadap poisoning attack meliputi teknik seperti robust training, outlier detection, dan data sanitization. Namun, mengingat kompleksitas serangan ini, pengembangan metode pertahanan yang lebih canggih tetap menjadi tantangan di bidang keamanan AI.

Exploratory Attack

Jenis-jenis serangan adversarial dalam pembelajaran mesin mencakup berbagai teknik yang dirancang untuk mengeksploitasi kelemahan model AI. Salah satu jenis serangan yang penting adalah exploratory attack, di mana penyerang mencoba memahami model target tanpa memodifikasinya secara langsung.

Exploratory attack bertujuan untuk mengumpulkan informasi tentang model dengan mengamati responsnya terhadap berbagai input. Penyerang tidak mengubah data pelatihan atau parameter model, tetapi menggunakan teknik seperti probing queries untuk memetakan perilaku sistem.

Contoh exploratory attack adalah model inversion attack, di mana penyerang mencoba merekonstruksi data pelatihan dengan menganalisis output model. Misalnya, dalam sistem pengenalan wajah, penyerang dapat menggunakan prediksi model untuk memperkirakan fitur wajah asli.

Jenis lain adalah membership inference attack, di mana penyerang menentukan apakah suatu sampel tertentu termasuk dalam data pelatihan model. Serangan ini dapat membocorkan informasi sensitif, terutama jika data pelatihan bersifat pribadi atau rahasia.

Exploratory attack sering menjadi langkah awal sebelum serangan yang lebih berbahaya, seperti evasion atau poisoning attack. Dengan memahami model secara mendalam, penyerang dapat merancang input adversarial yang lebih efektif.

Pertahanan terhadap exploratory attack meliputi pembatasan akses ke model, penerapan differential privacy, dan pengurangan informasi yang diberikan dalam output. Pendekatan ini membantu meminimalkan risiko kebocoran data dan meningkatkan keamanan sistem AI.

Dampak Adversarial pada Model Bahasa

Dampak adversarial pada model bahasa menjadi perhatian penting dalam pengembangan sistem pemrosesan bahasa alami (NLP). Serangan adversarial dapat memanipulasi input teks dengan perubahan halus seperti penggantian sinonim atau karakter khusus, menyebabkan model menghasilkan prediksi yang salah tanpa mengubah makna bagi pembaca manusia. Fenomena ini tidak hanya mengancam keandalan sistem NLP, tetapi juga berpotensi menimbulkan risiko keamanan dalam aplikasi kritis seperti deteksi spam, analisis sentimen, atau penerjemahan otomatis.

Kerentanan Model NLP

Dampak adversarial pada model bahasa dapat mengganggu kinerja sistem pemrosesan bahasa alami (NLP) dengan berbagai cara. Serangan berbasis teks sering kali memanipulasi input melalui penggantian kata, penambahan noise, atau modifikasi struktur kalimat yang sulit dideteksi manusia tetapi mampu mengecoh model.

Kerentanan model NLP terhadap serangan adversarial muncul karena ketergantungannya pada pola statistik daripada pemahaman semantik mendalam. Perubahan kecil seperti mengganti kata dengan sinonim atau menyisipkan karakter khusus dapat mengubah hasil klasifikasi secara signifikan, sementara makna teks tetap sama bagi pembaca manusia.

Contoh nyata termasuk modifikasi ulasan produk untuk mengelabui analisis sentimen, atau manipulasi teks dalam email phishing agar lolos dari filter spam. Serangan semacam ini mengeksploitasi celah dalam representasi vektor kata dan arsitektur model, menunjukkan kelemahan mendasar dalam pendekatan NLP modern.

Dampak serius lainnya adalah potensi penyebaran misinformasi melalui model generatif seperti chatbot atau sistem parafrase. Input adversarial dapat memicu output yang menyesatkan, bias, atau bahkan berbahaya tanpa disadari oleh pengguna akhir.

Untuk meningkatkan ketahanan, teknik seperti adversarial training dan pemeriksaan robustnes menjadi penting. Namun, tantangan utama tetap ada karena kompleksitas bahasa alami dan kemampuan penyerang untuk terus mengembangkan metode baru yang lebih canggih.

Contoh Manipulasi Output

Dampak adversarial pada model bahasa dapat menyebabkan kesalahan klasifikasi yang signifikan dalam sistem pemrosesan bahasa alami (NLP). Contoh manipulasi output termasuk penggantian kata kunci dengan sinonim atau karakter Unicode yang mirip, sehingga teks terlihat normal bagi manusia tetapi mengelabui model. Misalnya, mengubah kata “buruk” menjadi “t1d4k” dalam ulasan produk dapat membuat sistem analisis sentimen salah mengklasifikasikannya sebagai positif.

Serangan lain melibatkan penyisipan kata tidak relevan yang mengacaukan perhatian model tanpa mengubah makna kalimat. Contohnya, menambahkan frasa seperti “film bagus” dalam email penipuan agar lolos dari deteksi spam. Teknik ini memanfaatkan kelemahan model dalam menangani noise dan konteks panjang.

Pada model generatif seperti chatbot, input adversarial dapat memicu output berbahaya atau bias. Pertanyaan yang dirancang khusus bisa membuat model menghasilkan konten tidak pantas meski dengan penyaringan konten. Hal ini menunjukkan kerentanan sistem AI terhadap eksploitasi semantik.

Manipulasi output juga terjadi dalam terjemahan mesin, di mana perubahan kecil pada kalimat sumber menyebabkan terjemahan yang sangat berbeda. Contohnya, menyisipkan koma atau mengubah kapitalisasi dapat mengubah makna terjemahan secara drastis tanpa mengganggu keterbacaan teks asli.

Pertahanan terhadap serangan ini mencakup preprocessing teks untuk mendeteksi karakter anomali, augmentasi data dengan contoh adversarial, dan penerapan model ensemble. Namun, sifat dinamis bahasa membuat perlindungan penuh tetap menjadi tantangan besar dalam pengembangan NLP yang robust.

Teknik Pertahanan terhadap Adversarial

Teknik pertahanan terhadap serangan adversarial dalam pembelajaran mesin menjadi aspek krusial untuk memastikan keandalan dan keamanan sistem AI. Pendekatan ini mencakup berbagai metode seperti adversarial training, preprocessing input, dan deteksi anomali yang dirancang untuk meningkatkan ketahanan model terhadap manipulasi. Dalam konteks ini, pemahaman mendalam tentang mekanisme serangan dan pengembangan strategi pertahanan yang efektif sangat penting untuk melindungi aplikasi AI di berbagai bidang kritis.

Adversarial Training

Teknik pertahanan terhadap serangan adversarial dalam pembelajaran mesin mencakup berbagai pendekatan untuk meningkatkan ketahanan model AI. Salah satu metode utama adalah adversarial training, di mana model dilatih dengan contoh-contoh adversarial yang sengaja dibuat untuk menguji dan memperkuat ketahanannya.

Adversarial training bekerja dengan mengekspos model pada data yang telah dimodifikasi dengan perturbasi kecil selama proses pelatihan. Dengan demikian, model belajar mengenali pola serangan dan menjadi lebih robust terhadap input yang dimanipulasi. Teknik ini efektif untuk mengurangi dampak evasion attack dan meningkatkan akurasi prediksi pada kondisi nyata.

Metode pertahanan lain adalah gradient masking, yang menyembunyikan informasi gradien dari penyerang dengan membuat permukaan keputusan model lebih halus. Pendekatan ini mempersulit penyerang untuk menghitung perturbasi optimal yang diperlukan untuk mengecoh model.

Defensive distillation adalah teknik pertahanan yang melibatkan pelatihan model tambahan menggunakan prediksi model awal sebagai label. Proses ini menghasilkan model dengan permukaan keputusan yang lebih halus, mengurangi kerentanan terhadap serangan berbasis gradien.

Pendekatan preprocessing input juga penting dalam pertahanan adversarial. Teknik seperti feature squeezing mengurangi dimensi input dengan menggabungkan fitur serupa, sehingga perturbasi adversarial menjadi kurang efektif. Contohnya, mengurangi bit depth gambar dapat menghilangkan noise yang digunakan dalam serangan.

Deteksi anomali merupakan lapisan pertahanan tambahan yang mengidentifikasi input yang mencurigakan sebelum diproses oleh model utama. Sistem deteksi ini dapat menggunakan statistik, machine learning, atau aturan heuristik untuk memfilter contoh adversarial.

Pertahanan yang komprehensif sering kali menggabungkan beberapa teknik ini dalam arsitektur bertingkat. Pendekatan hybrid seperti adversarial training dengan preprocessing dan deteksi anomali memberikan perlindungan lebih kuat dibandingkan metode tunggal.

Pengembangan teknik pertahanan terus berevolusi seiring dengan kemunculan serangan baru. Penelitian terbaru fokus pada metode seperti certified defense yang memberikan jaminan teoritis terhadap serangan tertentu, serta adaptive defense yang dapat belajar dan beradaptasi dengan ancaman baru.

Input Sanitization

Teknik pertahanan terhadap serangan adversarial dalam pembelajaran mesin mencakup berbagai strategi untuk melindungi model AI dari manipulasi berbahaya. Salah satu pendekatan penting adalah input sanitization, yang bertujuan membersihkan atau memfilter data sebelum diproses oleh model.

Input sanitization bekerja dengan menghilangkan atau memodifikasi elemen mencurigakan dari data input yang mungkin mengandung perturbasi adversarial. Teknik ini dapat mencakup normalisasi teks, penghapusan karakter khusus, atau pemrosesan gambar untuk mengurangi noise yang berpotensi merusak.

Metode ini sering digunakan bersama teknik pertahanan lain seperti adversarial training untuk menciptakan lapisan keamanan ganda. Dengan membersihkan input terlebih dahulu, model menjadi lebih sulit dimanipulasi melalui serangan berbasis perturbasi halus.

Keuntungan utama input sanitization adalah kemampuannya bekerja tanpa memodifikasi arsitektur model yang ada. Pendekatan ini dapat diimplementasikan sebagai lapisan preprocessing, membuatnya relatif mudah diintegrasikan ke dalam sistem yang sudah berjalan.

Contoh penerapannya termasuk filter karakter untuk teks, transformasi warna pada gambar, atau pembatasan rentang nilai input. Teknik-teknik ini membantu memastikan data yang masuk memenuhi standar tertentu sebelum diproses lebih lanjut.

Meskipun efektif terhadap beberapa jenis serangan, input sanitization memiliki keterbatasan dalam menghadapi teknik adversarial yang lebih canggih. Oleh karena itu, pendekatan ini paling baik digunakan sebagai bagian dari strategi pertahanan multi-lapis yang komprehensif.

Perkembangan terbaru dalam input sanitization mencakup penggunaan model kecil khusus untuk mendeteksi dan membersihkan input mencurigakan sebelum mencapai model utama. Pendekatan ini meningkatkan keamanan tanpa mengorbankan kinerja sistem secara signifikan.

Model Robustness

Teknik pertahanan terhadap serangan adversarial dalam pembelajaran mesin mencakup berbagai metode untuk meningkatkan ketahanan model terhadap manipulasi. Salah satu pendekatan utama adalah adversarial training, di mana model dilatih menggunakan contoh serangan yang disimulasikan untuk memperkuat kemampuannya mengenali input yang dimanipulasi.

Metode lain yang efektif adalah defensive distillation, yang melibatkan pelatihan model tambahan menggunakan prediksi model awal sebagai label. Proses ini menghasilkan permukaan keputusan yang lebih halus, mengurangi kerentanan terhadap serangan berbasis gradien.

Pendekatan preprocessing input juga penting, seperti feature squeezing yang mengurangi dimensi input untuk meminimalkan efektivitas perturbasi adversarial. Teknik ini dapat mencakup pengurangan bit depth pada gambar atau normalisasi teks untuk menghilangkan karakter anomali.

Deteksi anomali berperan sebagai lapisan pertahanan tambahan dengan mengidentifikasi input mencurigakan sebelum diproses oleh model utama. Sistem ini dapat menggunakan statistik atau algoritma machine learning untuk memfilter contoh adversarial.

Strategi pertahanan yang komprehensif sering menggabungkan beberapa teknik ini dalam arsitektur bertingkat. Pendekatan hybrid seperti adversarial training dengan preprocessing dan deteksi anomali memberikan perlindungan lebih kuat dibandingkan metode tunggal.

Penelitian terbaru fokus pada pengembangan certified defense yang memberikan jaminan teoritis terhadap serangan tertentu, serta adaptive defense yang dapat belajar dan beradaptasi dengan ancaman baru. Teknik-teknik ini terus berevolusi seiring dengan kemunculan metode serangan yang lebih canggih.

Peningkatan model robustness juga melibatkan teknik seperti gradient masking yang menyembunyikan informasi gradien dari penyerang, membuatnya lebih sulit untuk menghitung perturbasi optimal. Pendekatan ini efektif terhadap serangan white-box yang memanfaatkan pengetahuan tentang arsitektur model.

Implementasi pertahanan adversarial memerlukan keseimbangan antara keamanan dan kinerja model. Solusi optimal sering kali tergantung pada aplikasi spesifik, tingkat ancaman, dan sumber daya komputasi yang tersedia untuk sistem tersebut.

Aplikasi Adversarial di Dunia Nyata

Aplikasi adversarial di dunia nyata menjadi tantangan serius dalam pengembangan sistem kecerdasan buatan. Serangan ini memanfaatkan kelemahan model AI dengan memanipulasi input melalui perubahan halus yang sulit dideteksi manusia, namun berdampak signifikan pada output sistem. Dari kendaraan otonom hingga sistem keamanan siber, ancaman adversarial menunjukkan kerentanan teknologi modern terhadap eksploitasi yang dapat membahayakan operasional berbagai layanan kritis.

Keamanan Siber

Aplikasi adversarial di dunia nyata telah menjadi ancaman serius dalam bidang keamanan siber. Serangan ini mengeksploitasi kelemahan model AI dengan memanipulasi input melalui perubahan kecil yang tidak terdeteksi manusia, tetapi berdampak besar pada output sistem.

Dalam keamanan siber, adversarial attack sering digunakan untuk menipu sistem deteksi malware. Penyerang dapat memodifikasi kode berbahaya dengan cara yang tidak mengubah fungsinya, tetapi membuatnya tidak terdeteksi oleh algoritma keamanan. Teknik ini memanfaatkan celah dalam model machine learning yang digunakan untuk analisis malware.

Sistem autentikasi berbasis wajah juga rentan terhadap serangan adversarial. Dengan menambahkan noise tertentu pada gambar atau menggunakan kacamata khusus, penyerang dapat mengelabui sistem pengenalan wajah untuk memberikan akses tidak sah. Serangan semacam ini membahayakan keamanan fisik dan digital di berbagai institusi.

Adversarial attack juga muncul dalam spam filtering, di mana penyerang memodifikasi email spam dengan perubahan kecil pada teks untuk menghindari deteksi. Teknik seperti penggantian kata dengan sinonim atau karakter Unicode yang mirip sering digunakan untuk mengecoh model klasifikasi tanpa mengubah makna pesan.

Dalam sistem rekomendasi, serangan adversarial dapat memanipulasi hasil dengan mengeksploitasi celah dalam algoritma. Penyerang dapat membuat akun atau konten palsu yang dirancang khusus untuk memengaruhi rekomendasi, baik untuk keuntungan finansial maupun penyebaran misinformasi.

Pertahanan terhadap serangan ini memerlukan pendekatan multi-lapis, termasuk pemantauan terus-menerus, pembaruan model reguler, dan implementasi teknik deteksi anomali. Kolaborasi antara peneliti keamanan siber dan pengembang AI menjadi kunci untuk mengatasi tantangan yang terus berkembang ini.

Deteksi Spam

Aplikasi adversarial dalam deteksi spam menjadi salah satu tantangan utama dalam keamanan sistem email modern. Penyerang terus mengembangkan teknik canggih untuk memanipulasi konten spam agar lolos dari filter berbasis AI.

- Penggantian kata kunci dengan karakter Unicode yang mirip

- Penyisipan teks acak untuk mengacaukan analisis semantik

- Penggunaan frasa positif untuk menetralkan analisis sentimen

- Modifikasi header email dengan teknik obfuscation

- Eksploitasi celah dalam model klasifikasi berbasis NLP

Serangan ini menunjukkan kerentanan sistem deteksi spam konvensional terhadap manipulasi adversarial. Perkembangan teknik pertahanan seperti adversarial training dan analisis perilaku menjadi penting untuk mempertahankan efektivitas filter spam di era serangan yang semakin canggih.

Analisis Sentimen

Aplikasi adversarial dalam analisis sentimen menunjukkan kerentanan model pemrosesan bahasa alami terhadap manipulasi yang dirancang untuk mengubah hasil klasifikasi. Teknik serangan ini sering kali memanfaatkan celah dalam representasi teks untuk mengecoh sistem tanpa mengubah makna yang dirasakan manusia.

- Penggantian kata kunci dengan sinonim atau variasi ejaan

- Penyisipan kata netral untuk mengubah distribusi fitur

- Modifikasi struktur kalimat dengan tetap mempertahankan konteks

- Eksploitasi ambiguitas semantik dalam model klasifikasi

- Penggunaan karakter khusus atau format teks tidak standar

Dampak serangan ini sangat terasa dalam sistem analisis ulasan produk atau media sosial, dimana manipulasi sentimen dapat memengaruhi keputusan bisnis dan persepsi publik. Pertahanan efektif memerlukan pendekatan holistik yang menggabungkan preprocessing teks, adversarial training, dan mekanisme deteksi anomali.

Riset dan Perkembangan Terkini

Riset dan perkembangan terkini dalam bidang Adversarial menunjukkan peningkatan kompleksitas serangan terhadap sistem kecerdasan buatan. Studi terbaru fokus pada teknik eksploitasi model melalui manipulasi input yang halus namun berdampak signifikan, terutama dalam konteks pemrosesan bahasa alami dan pengenalan pola. Penelitian ini tidak hanya mengungkap kerentanan sistem AI modern, tetapi juga mendorong inovasi dalam metode pertahanan yang lebih robust untuk menghadapi ancaman yang terus berevolusi.

Metode Baru dalam Serangan

Riset dan perkembangan terkini dalam bidang Adversarial menunjukkan kemajuan signifikan dalam metode serangan dan pertahanan. Penelitian terbaru mengungkap teknik serangan yang semakin canggih, khususnya dalam mengeksploitasi model pembelajaran mesin dan sistem berbasis AI.

- Pengembangan serangan berbasis optimisasi dengan perturbasi lebih halus

- Eksploitasi kerentanan model generatif seperti GPT dan DALL-E

- Serangan transfer lintas model yang efektif pada arsitektur berbeda

- Teknik poisoning yang menargetkan fase pelatihan model

- Adaptasi serangan untuk sistem waktu nyata seperti kendaraan otonom

Di sisi pertahanan, muncul pendekatan baru yang menggabungkan pembelajaran mesin dengan teknik keamanan tradisional. Peneliti fokus pada pengembangan sistem deteksi otomatis dan mekanisme respons adaptif terhadap ancaman adversarial yang dinamis.

Inovasi Pertahanan

Riset dan perkembangan terkini dalam inovasi pertahanan adversarial menunjukkan peningkatan signifikan dalam menghadapi ancaman terhadap sistem kecerdasan buatan. Penelitian terbaru fokus pada pengembangan teknik pertahanan yang lebih robust dan adaptif terhadap serangan yang semakin canggih.

- Penerapan adversarial training dengan dataset yang lebih beragam

- Pengembangan model ensemble untuk meningkatkan ketahanan

- Integrasi teknik certified defense dengan jaminan teoritis

- Pemanfaatan deteksi anomali berbasis AI

- Implementasi sistem monitoring real-time

Inovasi terbaru juga mencakup pendekatan hybrid yang menggabungkan preprocessing input dengan arsitektur model yang lebih aman. Tantangan utama tetap pada kecepatan adaptasi terhadap metode serangan baru yang terus berkembang.